Digital Maintenance und Digital Production: Einstieg in die Smarte Fabrik

Vom Schlagwort zur großen Prophezeiung

Die Prozessindustrie wird in vielen Veröffentlichungen als Spätentwickler der Digitalisierung gehandelt. Aber dieses Bild trügt. Im Gegenteil: Kaum eine Industrie eignet sich besser für den Einstieg in die Smarte Fabrik als die Prozessindustrie! Beim 8. Jahrestreffen der Betriebsingenieure stellt der Autor die These auf: Verfahrenstechnische Anlagen können bereits heute zur Smarten Fabrik werden.

Warum sind so viele Entscheider und Spezialisten zurückhaltend, wenn es um Digitale Transformation in Chemie, Kraftwerk oder Pharma geht? Der Übergang zur digitalen Industrie löst bei vielen Personen Unwohlsein und Ängste aus. Das liegt zum Teil daran, dass die Digitalisierung bereits viele gesellschaftliche Vorgänge verändert hat und die Auswirkungen bis in das Privatleben hinein spürbar sind. Diese Veränderungen sind zum Teil massiv, denn Digitalisierung ist ihrem Kern nach disruptiv. Das bedeutet, dass die bestehenden Marktmechanismen und Wirkprinzipien teilweise oder vollständig außer Kraft gesetzt und durch neue ersetzt werden.

Diese neuen Wirkprinzipien lassen sich am Beispiel dreier erfolgreicher Unternehmen erläutern:

Beispiel 1: Amazon

Die Digitalisierung ermöglicht eine weltweite Marktdurchdringung mit hoher Geschwindigkeit. Das bekannteste Beispiel ist Amazon. Amazon errichtet schnell neue Marktbarrieren, die danach nur noch schwierig zu durchbrechen sind.

Beispiel 2: Facebook

Daten werden heute wie das „Öl des 21. Jahrhunderts“ gehandelt. Die Facebook-Investoren haben dies früh erkannt und das Unternehmen mit enormen Finanzmitteln ausgestattet, und zwar zu einem Zeitpunkt, an dem weder der konkrete Nutzen der Daten noch ein Geschäftsmodell erkennbar waren. Facebook hat sozusagen bereits nach Öl gebohrt, als es weder Raffinerien noch Autos gab.

Beispiel 3: Apple

Was „Disruption“ für die Industrie bedeutet, macht das Smartphone deutlich: das iPhone ist 2007 vorgestellt worden. In weniger als zehn Jahren danach wurden gleich mehrere Branchen in ihrem Geschäft bedroht oder verändert: In Musikindustrie, Kameraindustrie und Telekommunikation ist kein Stein auf dem anderen geblieben, die Autoindustrie hat die IT-Konnektivität als Geschäft entdeckt, und die zukünftige Smart Home-Technologie ist bereits als App auf unseren Mobilgeräten installiert. Die Veränderung beginnt sozusagen direkt an unserer Haustür.

Die Prozessindustrie scheint im Vergleich dazu wie gelähmt. Beim Versuch, diese Wirkprinzipien auf die Verfahrensindustrie zu übertragen, müssen sich die

Unternehmen folgenden Fragen und Herausforderungen stellen:

- Wie soll es konkret in der Prozessindustrie funktionieren, mithilfe von Daten Marktbarrieren oder Monopole zu errichten?

- Warum soll man in das Sammeln von Daten investieren, ohne den messbaren Nutzen eines konkreten Business Cases absehen zu können?

- Werden die bisherigen Marktkräfte wirklich radikal verändert oder ist das alles nur ein Medienhype?

Das, was im Privaten erlebt und in den Medien proklamiert wird, passt nicht zur aktuellen Realität der produzierenden Prozessindustrie. Diese kognitive Dissonanz führt bei vielen Entscheidern und Spezialisten zu einem Gefühl von Unsicherheit und Orientierungslosigkeit. Aber ist das die faktische Realität?

Bei sachlicher und analytischer Herangehensweise entsteht ein anderes Bild: Die Ausgangslage für die erfolgreiche Digitale Transformation ist in der verfahrenstechnischen Industrie geradezu optimal.

Die Faktenlage: Digitalisierung bietet einmalige Chancen für die Prozessindustrie

Faktisch setzt sich das Bild in der Prozessindustrie wie folgt zusammen:

Daten: Es liegen gute, teilweise sogar sehr gute Big-Data-Historien mit hoher Qualität vor. Sie finden sich in Archiven, Prozessleitsystemen, Condition Monitoring-Systemen, Steuerungen und sogar im SAP. Die Prozessindustrie ist seit den 1990er Jahren ein Vorreiter der Automatisierung. Das kann sich jetzt auszahlen.

Schnittstellen: Die Daten sind häufig mit relativ geringem Aufwand extrahierbar, zu verarbeiten und für maschinelles Lernen nutzbar zu machen. Viele Schnittstellen sind OPC-standardisiert.

Optimierungen: Mit den Daten können wir heute schon kurzfristige, messbare Verbesserungen in Produktion und Instandhaltung durchführen. Das ist die beste Basis für neue Geschäftsmodelle, gerade bei der Produktoptimierung zum Kunden hin.

Methoden: Maschinelles Lernen liefert erstklassige Werkzeuge, sowohl für die konkreten Optimierungen als auch für die weitere Digitalisierung. Aufgrund des demografischen Wandels, des Mangels an menschlichen Ressourcen oder des hohen Energieanteils an den Herstellkosten lassen sich konkrete Business Cases für digitale Optimierungen finden.

Umsetzung: Mit dieser Ausgangsbasis hat die Prozessindustrie das beste Potenzial, zum Vorreiter für Industrie 4.0 zu werden.

Die Hemmnisse: Neue Anforderungen, schlechte Erfahrungen, scheinbares Expertenwissen und Silos

Aber warum gibt es überall noch Widerstände, wenn die Umsetzung scheinbar so einfach ist? Es können drei mögliche Ursachen identifiziert werden, warum Entscheider in der Prozessindustrie trotz großer Chancen die Digitalisierung relativ zögerlich angehen:

Ursache 1: Neue Anforderungen an Methoden und Technologie-Kenntnis

Naturwissenschaftler und Ingenieure besitzen aufgrund ihrer Ausbildung einen hohen Grad an mathematischen Fähigkeiten. In der Praxis sind sie sich dieser Fähigkeiten jedoch häufig nicht bewusst, weil ein großer Teil ihrer Tagesarbeit aus Routinen, Organisation und Management besteht. Es fehlt an der Übung. Die wenigen Analysen beschränken sich auf einfache statistische Methoden und auf das Abbilden linearer Zusammenhänge mit wenig Variablen.

Die Realität einer Prozessanlage ist aber hochgradig nicht-linear und multivariat. Also werden moderne Data Analytics benötigt. Die Kenntnisse zu deren Einsatz lassen sich häufig bereits innerhalb von Pilotprojekten aufbauen.

Ursache 2: Hemmung durch früher gemachte Erfahrungen

Viele frühe Innovatoren und Investoren wurden nicht belohnt, als sie modernste Data Analytics-Methoden zu früh ausprobierten. Die Leistungsfähigkeit der Software und vor allem der Computer war vor 15 Jahren noch nicht ausgereift genug. Das hat sich mittlerweile radikal gewandelt und selbst die omnipräsenten Smart Phones arbeiten heute mit künstlicher Intelligenz.

Ursache 3: Lähmung durch Silos und Experten

Viele IT-Abteilungen der großen Unternehmen hatten sich in den letzten 20 Jahren komplett auf SAP ausgerichtet. IT galt nicht als Kernkompetenz, sondern als Kostenfaktor. Wer modernste IT zur Prozesssteuerung und Fabrikoptimierung einsetzen wollte, blieb häufig auf sich gestellt. Mittlerweile gibt es Plattformen, die die dabei entstandenen Datensilos heute wieder integrieren helfen.

Ein weiterer Hemmschuh für Innovation ist häufig der Experte im eigenen Unternehmen. Experten haben sich in Detailabläufe und komplexe Prozesse intensiv eingearbeitet und genießen daher hohe Anerkennung für ihr Spezialwissen. Aus naheliegendem Grund lehnen sie Neues und Unbekanntes zunächst ab. Darin stecken meist die besten Absichten, denn sie wollen das Unternehmen vor scheinbaren Fehlentscheidungen schützen. Diese Experten und ihr Know-How sollten daher eng ins Team integriert, ihre Bedenken ernst genommen und mit nachvollziehbaren Resultaten überzeugt werden. Dies kann am Beispiel des Maschinellen Lernens erfolgreich demonstriert werden.

Die Lösung: Maschinelles Lernen ermöglicht beides.

Optimierung und Digitalisierung

Der Einsatz von Maschinellem Lernen kann ein Treiber gleichermaßen für Optimierungen und Digitalisierung sein. Eine wichtige Grundlage für Maschinelles Lernen ist die Art und Weise, wie Daten erzeugt werden. Daten aus industriellen Anlagen entstehen nicht zufällig, sondern sie werden alle nach Regeln erzeugt. Diese Regeln sind aus Mathematik, Natur und Ingenieurwissenschaften bekannt.

Industrielle Systeme sind deterministisch. Das heißt, dass Ursachen und Wirkungen über Naturgesetze miteinander verknüpft sind. Selbstverständlich gibt es auch Phänomene, die unkontrollierbar von außen auf das System einwirken – Dinge wie an An- und Abfahren, Qualitätsschwankungen bei Einsatzmaterialien oder Änderungen der Umgebungsbedingungen.

Das System selbst reagiert deterministisch auf diese Änderungen. Nichts passiert ohne Grund, auch wenn nicht unbedingt alle Zusammenhänge erkennbar sind.

Ein Neuronales Netz, die Basis für Maschinelles Lernen, kann diese Zusammenhänge erlernen. Nach kurzer Zeit „weiß“ die Maschine also Dinge, die dem Menschen bisher verschlossen blieben. Das Lernen funktioniert rein empirisch, also ausschließlich auf Basis von Daten. Die Daten stammen aus der Sensorik der Anlage. Das Ergebnis nennt man Datenmodell. Man kann zeigen, dass ein Neuronales Netz immer ein präzises Datenmodell entwickelt, sofern die Daten regelbasiert erzeugt werden. Es gibt also sozusagen einen mathematischen Beweis dafür, dass Neuronale Netze auf industrielle Anlagen passen.

Ein Neuronales Netz liefert also ein Bild der Wirklichkeit der Anlage. Eine spezielle Form von Maschinellem Lernen ist das Rekurrente Neuronale Netz. Mit seiner Hilfe lässt sich ein Zeitgedächtnis verwirklichen. Damit kann man nun Ursachen und Wirkungen auch über weite Zeiträume abbilden.

Solche Datenmodelle sind aus der Systemdynamik bekannt. Das Datenmodell ist ein Differentialgleichungssystem, und in der Regelungstechnik wird es die Übertragungsfunktion genannt. Die Übertragungsfunktion beschreibt also, wie aus Input-Zeitdaten Output-Zeitdaten werden, oder einfach: Wie die Daten in der Anlage sich verändern.

Für den Menschen wäre das Berechnen der Übertragungsfunktion einer gesamten Anlage zu aufwändig. Die Formel müsste ständig angepasst werden, weil sich Zustand und Prozess der Anlage andauernd verändern. Ein lernender Algorithmus erledigt dies in Echtzeit. Er bildet nicht nur ein Datenmodell, sondern passt es automatisch an, wenn er weiter mit Daten versorgt wird.

In der Praxis heißt das, dass ‚Maschinelles Lernen‘ sich gut eignet, um ständig wechselnde Sensordaten in ein empirisches Anlagenmodell zu überführen und es kontinuierlich zu aktualisieren. Dies ermöglicht eine Überwachung der Anlage. Wir können dem Datenmodell aber auch ein messbares Ziel vorgeben. Das kann z. B. eine bestimmte Qualität, eine höhere Leistung oder ein geringerer Verbrauch sein. Dies sind dann die gewünschten Zielfunktionen. Kennt das System die Zielfunktion, kann ein Lösungsalgorithmus dem Anlagenfahrer Maßnahmen vorschlagen, um das Optimum im aktuellen Betrieb zu finden. Typischerweise sind die Maßnahmen Veränderungen an den Sollwerten des Prozesses.

Noch einmal zusammengefasst: Das Modell wird mit historischen Daten angelernt und ausführlich getestet. Danach wird es an die Anlage, genauer gesagt an die Sensorik oder an das Datenarchiv des Leitsystems, angeschlossen. Es aktualisiert sich automatisch durch selbstständiges Weiterlernen. Mithilfe dieses Modells kann man nun Aussagen über die Wirklichkeit der Anlage treffen. Typische Aussagen sind Überwachen der Anlage, Optimieren ihres Betriebs oder Prognostizieren eines Zustands.

Konkrete Anwendungen: Smart Production und Smart Maintenance

Wie kann man nun konkret solche Modelle für die Optimierung und Digitalisierung nutzen? Zwei Beispiele aus Produktion und Instandhaltung zeigen, wie maschinelles Lernen den Menschen bei sehr komplexen Routineaufgaben unterstützen kann.

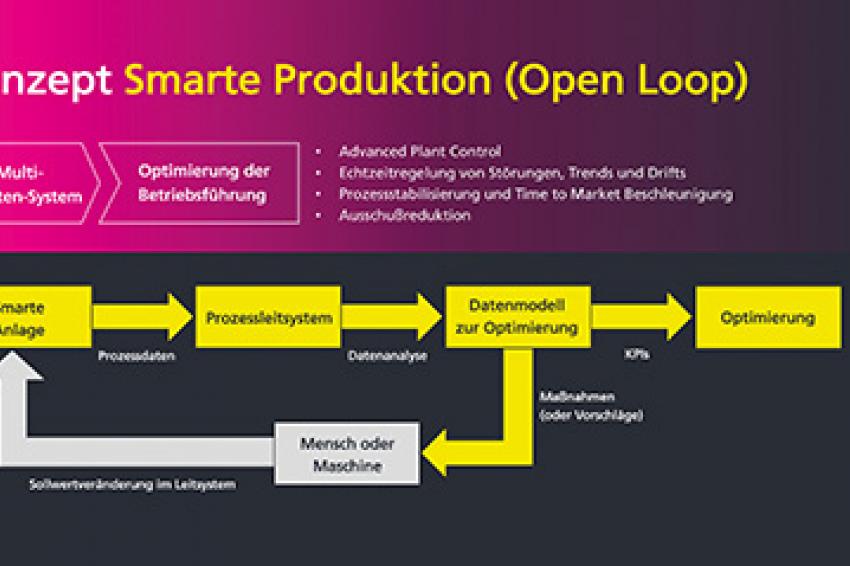

1. Produktionsoptimierung

In Chemieanlagen und Kraftwerken sind viele Bausteine der Smarten Fabrik bereits im operativen Einsatz. Am besten eignen sich automatisierte oder teilautomatisierte Anlagen, deren Sensordaten auf ein Monitoringsystem, eine Vorort-Steuerung oder ein Prozessleitsystem geführt und archiviert werden.

Das Bilden des Datenmodells erfordert etwas Aufwand bei der Vorbereitung der Daten. Damit wird der Maschine das Lesen der Daten ermöglicht. Das ist eine einmalige Aufgabe. Jedes Datenmodell sollte ausführlich getestet werden, erst danach wird es an das Informationssystem angeschlossen. Es kann nun für eine beliebige Zielfunktion die optimalen Einstellungen ableiten.

Das System schlägt dem Betriebsteam verbesserte Einstellungen vor. Die Anlagenfahrer verändern daraufhin die Sollwerte im Leitsystem. Die letzte Entscheidung, ob eine solche Maßnahme durchgeführt werden soll, obliegt heute immer noch dem Betriebsteam. Der Mensch behält also die Entscheidungshoheit und die Kontrolle über die tatsächliche Anlagenfahrweise.

Eine Optimierung von 10 % oder mehr ist in Chemieanlagen keine Seltenheit. In Kraftwerken besteht die Verbesserung meist darin, dass neue Betriebspunkte schneller und flexibler angefahren werden können als mit ausschließlich menschlicher Erfahrung.

Ein wichtiger Aspekt ist das Change-Management. Die Mannschaft sollte eng in die Entwicklung des Datenmodells einbezogen werden, um schrittweise Vertrauen in das Vorgehen zu gewinnen. Das gilt natürlich auch für die Optimierung der Instandhaltung.

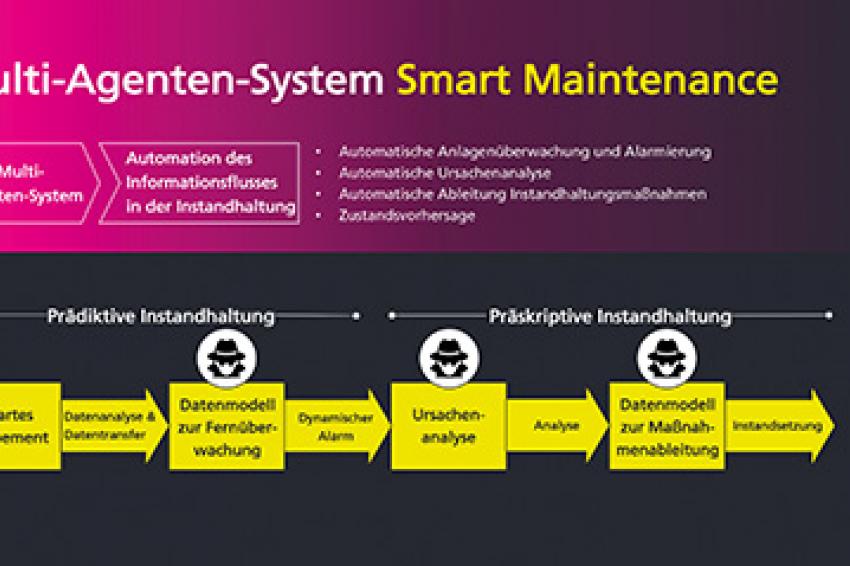

2. Smart Maintenance

In einer vollständigen Smart Maintenance-Umgebung lassen sich bis zu drei Datenmodelle einsetzen:

- Anlagenüberwachung: Das Datenmodell für die Anlagenüberwachung erlernt, wann der Zustand eines Equipments „gesund“ ist. Die Grenzwerte werden dynamisch passend zum Betriebsverhalten errechnet. Eine Abweichung davon wird automatisch erkannt und alarmiert.

- Ursachenanalyse: An der Form der Abweichung kann ein zweites Datenmodell erkennen, welche Ursache für die Abweichung verantwortlich ist.

- Maßnahmenableitung: Ist die Ursache erkannt, wird sie mit einer Instandhaltungsmaßnahme verbunden. Die Maßnahme wird dann dem Menschen automatisch auf ein Endgerät, z. B. ein Smartphone oder Tablet, gesendet.

Mit dieser Entscheidungskette wird es möglich, viele informationsgetriebene Routinen durch Maschinen zu bewältigen.

Digitalisierung ist die Chance für die Prozessindustrie

Datenmodelle aus Neuronalen Netzen sind gut geeignet, um Prozesse in der Verfahrenstechnik zu optimieren:

- Smart Equipments und Smart Plants sind weiter verbreitet als allgemein vermutet

- Datenmenge und Datenvielfalt sind kein Problem, sondern ein Vorteil, da mit großer Datenmenge auch die Präzision der Modelle ansteigt.

- Datenmodelle können automatisch gebildet und aktualisiert werden, da die Daten regelbasiert erzeugt werden.

- Verfahrenstechnische Anlagen eignen sich aufgrund der zentralen Datenhaltung in Prozessleitsystemen sogar noch besser als andere industrielle Anlagen für die Digitalisierung.

Die Optimierungen lassen sich leicht in Prozessbeschleunigungen, dem Auffangen kritischen Know-Hows bei demografischer Veränderung oder in effektiven Produktionsverbesserungen rechnen.

Das automatische (Weiter)Lernen des Systems ermöglicht es den Mitarbeitern, die alltäglichen Routinen der Maschine zu überlassen und sich z. B. auf neue Herausforderungen, kreative Freiräume, Prozessoptimierungen oder den Wissenstransfer mit Kollegen zu konzentrieren.

Dem Einstieg in die Digitalisierung steht also nichts mehr im Wege. Vor allem, wenn die neuen Techniken und Methoden als Chance verstanden werden: Als Chance, Anlagen und Prozesse besser zu verstehen. Als Chance, die Möglichkeiten zur Verbesserung zu entdecken. Und als Chance, die Prozessindustrie in vielen Bereichen zukunftsgerichtet aufzustellen.

Kontakt

Ahorner & Partner<Unternehmensberatung u. Marketing

Hornser Weg 5

40882 Ratingen

+49 173 2707035